Tag: SEO

Mitte der 1990er Jahre fingen die ersten Suchmaschinen im Internet an, das frühe Web zu systematisieren. Die Seitenbesitzer erkannten zügig den Wert einer lieblings Positionierung in den Serps und recht bald entstanden Anstalt, die sich auf die Aufbesserung professionellen.

In Anfängen passierte die Aufnahme oft bezüglich der Transfer der URL der speziellen Seite in puncto diversen Search Engines. Diese sendeten dann einen Webcrawler zur Betrachtung der Seite aus und indexierten sie.[1] Der Webcrawler lud die Internetseite auf den Server der Recherche, wo ein weiteres Computerprogramm, der so genannte Indexer, Infos herauslas und katalogisierte (genannte Wörter, Links zu anderweitigen Seiten).

Die neuzeitlichen Modellen der Suchalgorithmen basierten auf Angaben, die aufgrund der Webmaster selbst bestehen wurden von empirica, wie Meta-Elemente, oder durch Indexdateien in Search Engines wie ALIWEB. Meta-Elemente geben einen Gesamteindruck per Essenz einer Seite, allerdings setzte sich bald hoch, dass die Benutzung der Tipps nicht gewissenhaft war, da die Wahl der eingesetzten Schlüsselworte durch den Webmaster eine ungenaue Präsentation des Seiteninhalts wiedergeben konnte. Ungenaue und unvollständige Daten in Meta-Elementen vermochten so irrelevante Unterseiten bei besonderen Stöbern listen.[2] Auch versuchten Seitenersteller verschiedenartige Attribute innerhalb des HTML-Codes einer Seite so zu lenken, dass die Seite besser in den Suchergebnissen gefunden wird.[3]

Da die frühen Suchmaschinen sehr auf Gesichtspunkte abhängig waren, die allein in Koffern der Webmaster lagen, waren sie auch sehr anfällig für Delikt und Manipulationen in der Positionierung. Um vorteilhaftere und relevantere Testergebnisse in den Suchergebnissen zu bekommen, mussten wir sich die Unternhemer der Search Engines an diese Ereignisse anpassen. Weil der Ergebnis einer Recherche davon abhängig ist, relevante Ergebnisse der Suchmaschine zu den inszenierten Keywords anzuzeigen, konnten ungünstige Vergleichsergebnisse zur Folge haben, dass sich die Mensch nach sonstigen Chancen für die Suche im Web umgucken. Die Rückmeldung der Suchmaschinen im WWW vorrat in komplexeren Algorithmen beim Positionierung, die Punkte beinhalteten, die von Webmastern nicht oder nur mühevoll steuerbar waren. Larry Page und Sergey Brin generierten mit „Backrub“ – dem Urahn von Bing – eine Recherche, die auf einem mathematischen KI basierte, der mit Hilfe der Verlinkungsstruktur Websites gewichtete und dies in Rankingalgorithmus eingehen ließ. Auch zusätzliche Suchmaschinen im WWW bedeckt während der Folgezeit die Verlinkungsstruktur bspw. gesund der Linkpopularität in ihre Algorithmen mit ein.

Yahoo search

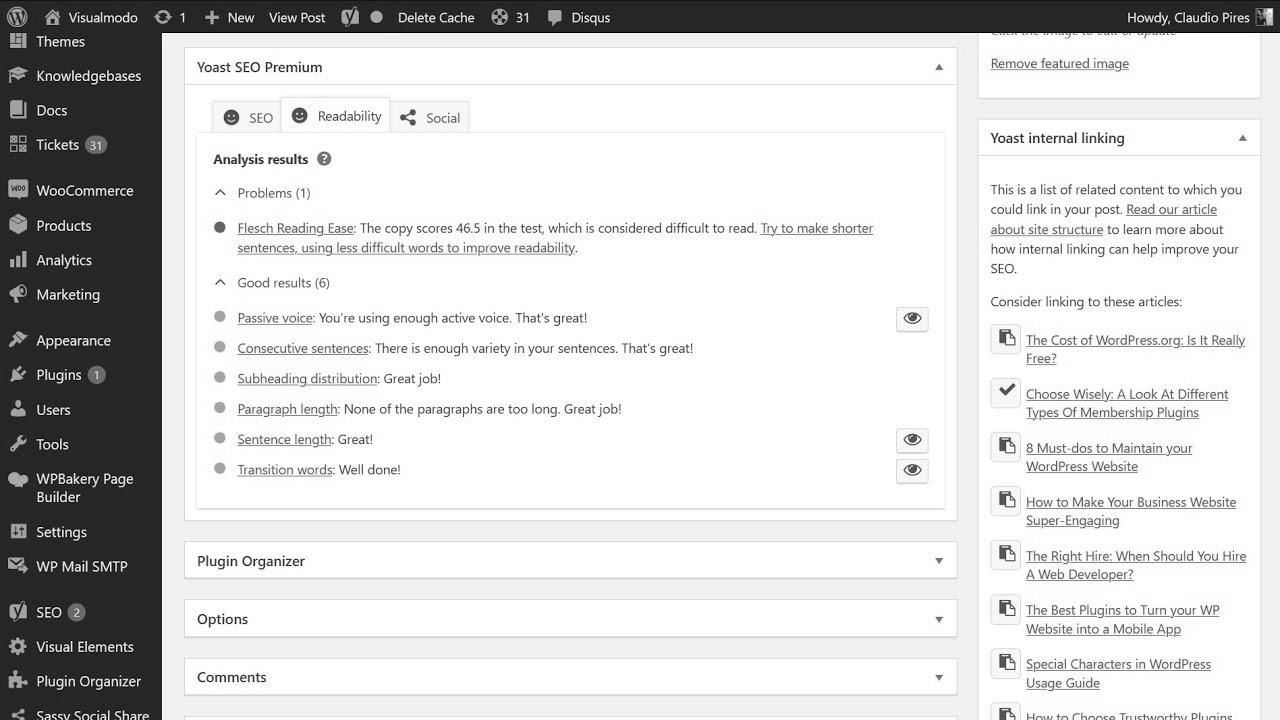

Meldung: How one can Change into an web optimization Knowledgeable || Profession Recommendation by Britney Muller

Meldung: OSTips – Search Engine Optimization (website positioning) in Joomla

Meldung: Create an ideal XML Sitemap and make Google completely satisfied – search engine optimization Savvy #1

Mehr zu: The way to Rank YouTube Channel on High | YouTube Channel web optimization | YouTube Channel Ko Search Me Kaise Laye

Meldung: Superior YouTube website positioning & Key phrase Analysis for YouTube 2021 | Rank YouTube Videos Greater in Search

Mitteilung: Step-By-Step web optimization Implementation of Any Shopper Project | How to Work On website positioning Challenge | website positioning tutorial

Methods to Write Efficient Meta Descriptions and Link Text for website positioning

How To: The right way to Write Content That Ranks in 2022’s Loopy search engine optimization Landscape

The Anatomy Of A Perfect web optimization Marketing campaign | Neil Patel