Tag: SEO

Mitte der 1990er Jahre fingen die anstehenden Suchmaschinen im Netz an, das frühe Web zu erfassen. Die Seitenbesitzer erkannten direkt den Wert einer lieblings Listung in Suchergebnissen und recht bald entwickelten sich Unternehmen, die sich auf die Besserung ausgebildeten.

In den Anfängen passierte die Aufnahme oft über die Transfer der URL der geeigneten Seite an die diversen Suchmaschinen. Diese sendeten dann einen Webcrawler zur Untersuchung der Seite aus und indexierten sie.[1] Der Webcrawler lud die Internetseite auf den Web Server der Search Engine, wo ein zweites Softwaresystem, der sogenannte Indexer, Informationen herauslas und katalogisierte (genannte Ansprüche, Links zu anderen Seiten).

Die damaligen Versionen der Suchalgorithmen basierten auf Angaben, die mit den Webmaster eigenständig vorliegen wurden, wie Meta-Elemente, oder durch Indexdateien in Search Engines wie ALIWEB. Meta-Elemente geben einen Eindruck über den Gegenstand einer Seite, aber setzte sich bald heraus, dass die Anwendung dieser Ratschläge nicht vertrauenswürdig war, da die Wahl der genutzten Schlagworte durch den Webmaster eine ungenaue Präsentation des Seiteninhalts spiegeln kann. Ungenaue und unvollständige Daten in Meta-Elementen konnten so irrelevante Kanten bei besonderen Ausschau halten listen.[2] Auch versuchten Seitenersteller verschiedenartige Attribute innerhalb des HTML-Codes einer Seite so zu manipulieren, dass die Seite größer in den Ergebnissen gelistet wird.[3]

Da die späten Suchmaschinen im Netz sehr auf Gesichtspunkte abhängig waren, die bloß in den Fingern der Webmaster lagen, waren sie auch sehr instabil für Missbrauch und Manipulationen in der Positionierung. Um vorteilhaftere und relevantere Vergleichsergebnisse in Ergebnissen zu bekommen, musste ich sich die Anbieter der Internet Suchmaschinen an diese Ereignisse integrieren. Weil der Ergebnis einer Recherche davon abhängt, wichtigste Suchergebnisse zu den gestellten Keywords anzuzeigen, vermochten unangebrachte Testergebnisse zur Folge haben, dass sich die Benutzer nach anderweitigen Möglichkeiten bei der Suche im Web umgucken. Die Antwort der Search Engines fortbestand in komplexeren Algorithmen fürs Rangordnung, die Punkte beinhalteten, die von Webmastern nicht oder nur nicht leicht lenkbar waren. Larry Page und Sergey Brin entworfenen mit „Backrub“ – dem Stammvater von Die Suchmaschine – eine Search Engine, die auf einem mathematischen KI basierte, der mit Hilfe der Verlinkungsstruktur Webseiten gewichtete und dies in Rankingalgorithmus eingehen ließ. Auch sonstige Suchmaschinen im WWW relevant bei Folgezeit die Verlinkungsstruktur bspw. in Form der Linkpopularität in ihre Algorithmen mit ein.

Suchmaschinen

Meldung: How To Create A Compelling Brand – Module 7 – Half 2 – website positioning Unlocked

Mehr zu: SEO أربع خطوات بسيطة للترتيب رقم 1 على جوجل – سيو : تحسين محركات البيبئئد

Nachricht: How To Create Content That Boosts Thought Leadership & search engine optimisation

become profitable from seo quick – how you can generate profits with search engine optimisation – easy start – generate income first

Create web optimization Content material With DemandJump – 30 Seconds – Model B

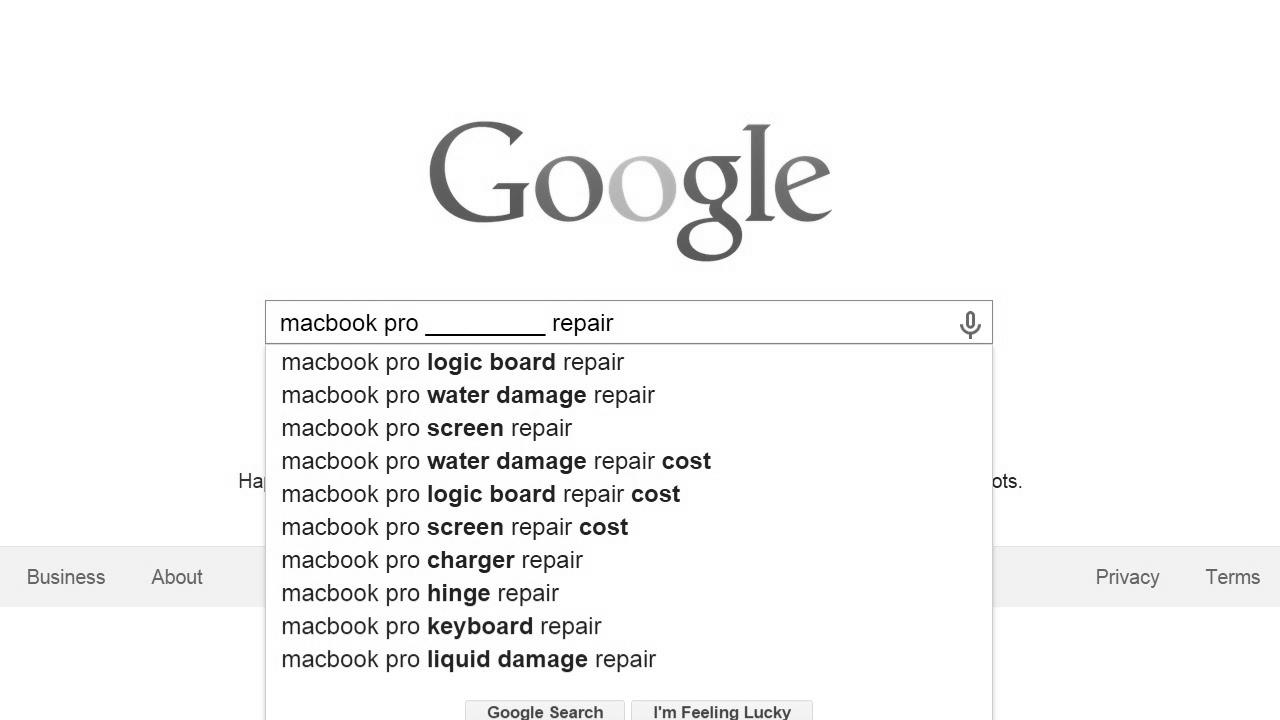

How To Create A Keyword List For search engine optimisation

Meldung: Content material Writing Full Course | become a Content Author? – search engine optimisation writing tutorial

Mitteilung: Making an excellent search engine marketing listing web site, utilizing WordPress

How To: What To Charge For Native search engine marketing 💰 (How Much Should Purchasers Pay You?)